Ten miesiąc nie pozostawia złudzeń, sztuczna inteligencja stała się polem największego starcia w historii branży IT. Z jednej strony rekordowe inwestycje i sojusze między gigantami, z drugiej, nowe układy, które przesuwają granice wydajności. W tle coraz mocniej widać też ruchy dostawców oprogramowania, którzy wprowadzają sztuczną inteligencję wprost do codziennej pracy przedsiębiorstw.

Wszystko to sprawia, że wrzesień trudno uznać za “kolejny zwykły miesiąc”. To moment, w którym układa się nowa mapa sił w branży. Od infrastruktury, przez software, po regulacje. Firmy muszą coraz szybciej podejmować decyzje: jak, kiedy i z kim wejść w świat AI na masową skalę.

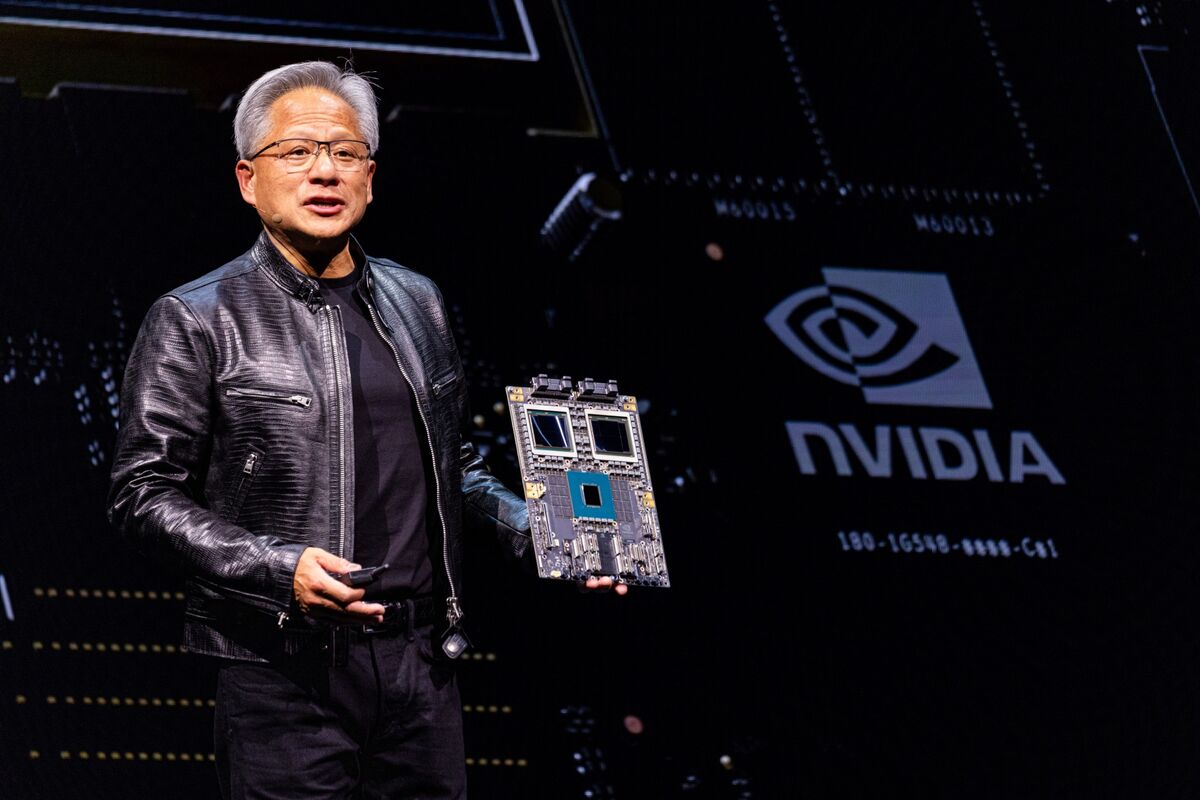

NVIDIA inwestuje we wszystko – od Intela, przez OpenAI, po nową generację układów

Wrzesień należał do NVIDII, która zagrała na kilku frontach jednocześnie, umacniając pozycję nie tylko lidera technologii, ale i finansowego inwestora. Już 18 września ogłoszono, że NVIDIA zainwestuje 5 miliardów dolarów w Intela, obejmując około 4% udziałów. To ruch, który jeszcze kilka miesięcy temu wydawałby się nie do pomyślenia. Firma, która dominuje na rynku akceleratorów AI, decyduje się wesprzeć swojego dawnego rywala. W praktyce to jednak nie tylko inwestycja kapitałowa, ale i strategiczna współpraca. Intel ma produkować część układów dla NVIDII w ramach usług foundry, a w zamian zyskuje potężne wsparcie finansowe i stabilniejszą pozycję na rynku półprzewodników.

Jeszcze ciekawszy jest jednak szerszy kontekst tej współpracy. W ramach rozmów zapowiedziano wspólny projekt procesorów Intela ze zintegrowanymi układami RTX. Taki ruch mógłby całkowicie zmienić sposób działania lokalnej sztucznej inteligencji na komputerach osobistych i stacjach roboczych, bo moc układów NVIDII wciąż nie ma konkurencji na rynku. To oznacza, że komputery klasy PC i laptopy mogłyby otrzymać natywną, sprzętową akcelerację AI znacznie potężniejszą niż rozwiązania NPU od Intela czy AMD.

W tle pojawia się też inny wątek. Intel od miesięcy rozważa sprzedaż działu Network & Edge (NEX). Nie jest tajemnicą, że NVIDIA, po przejęciu Mellanoxa, stała się potęgą w obszarze infrastruktury sieciowej dla centrów danych. Gdyby to właśnie “zieloni” przejęli NEX, powstałaby unikalna synergia: od GPU i CPU, przez interconnect, aż po kompletne rozwiązania serwerowe. To wizja, która mogłaby radykalnie przeobrazić układ sił na rynku infrastruktury AI.Kilka dni po ogłoszeniu inwestycji w Intela NVIDIA zaskoczyła jeszcze mocniej, podpisując porozumienie z OpenAI o wartości nawet 100 miliardów dolarów. Umowa zakłada, że OpenAI w kolejnych latach kupi co najmniej 10 GW mocy obliczeniowej w postaci serwerów GPU, a w zamian NVIDIA obejmie pakiet udziałów mniejszościowych w firmie Sama Altmana. To największy jak dotąd sojusz w świecie sztucznej inteligencji, jeden gracz dostarcza modele, drugi infrastrukturę. Razem budują duopol, który jeszcze mocniej zamyka rynek na konkurencję.

Nie mniej istotna była premiera nowej klasy procesorów serii Rubin CPX AI Superchip. To akcelerator AI zaprojektowany specjalnie do pracy z gigantycznymi modelami LLM, sięgającymi ponad miliona tokenów. W praktyce oznacza to możliwość “czytania” całych repozytoriów kodu czy ogromnych zbiorów danych w jednym przebiegu. Rubin CPX nie tylko zwiększa przepustowość i moc obliczeniową, ale też wymusza kolejne modernizacje w centrach danych, od szybszych sieci (800 GbE) po wdrożenie nowej generacji układów z pamięcią HBM4.

Te ruchy pokazują pełną skalę strategii NVIDII. Firma nie jest już tylko producentem GPU, inwestuje w konkurencję, dyktuje warunki największym twórcom AI i jednocześnie ustawia poprzeczkę technologiczną dla całej branży.

Intel nie składa broni – nowe procesory, GPU i rozmowy z Apple

Podczas gdy NVIDIA rozdaje karty na rynku AI, Intel próbuje udowodnić, że wciąż liczy się w grze. Wrzesień pokazał, że firma, mimo problemów finansowych i restrukturyzacji, stawia na kilka odważnych kierunków rozwoju.Na prestiżowej konferencji Hot Chips zaprezentowano Clearwater Forest, następną generację procesorów serwerowych Xeon opartych wyłącznie na rdzeniach E-core. Flagowy model ma oferować aż 288 rdzeni, a zastosowany proces Intel 18A i technologia pakowania 3D mają przynieść znaczący skok wydajności: o 17% w IPC (SPECint 2017) i nawet 3,5-krotnie lepszą efektywność energetyczną względem poprzedniej generacji Sierra Forest. To sygnał, że Intel świadomie stawia na segmenty, w których liczy się gęstość obliczeń i zużycie energii, czyli obsługę i wdrażanie modeli AI czy zadań sieciowych, zamiast ścigać się wyłącznie z GPU w treningu największych modeli.

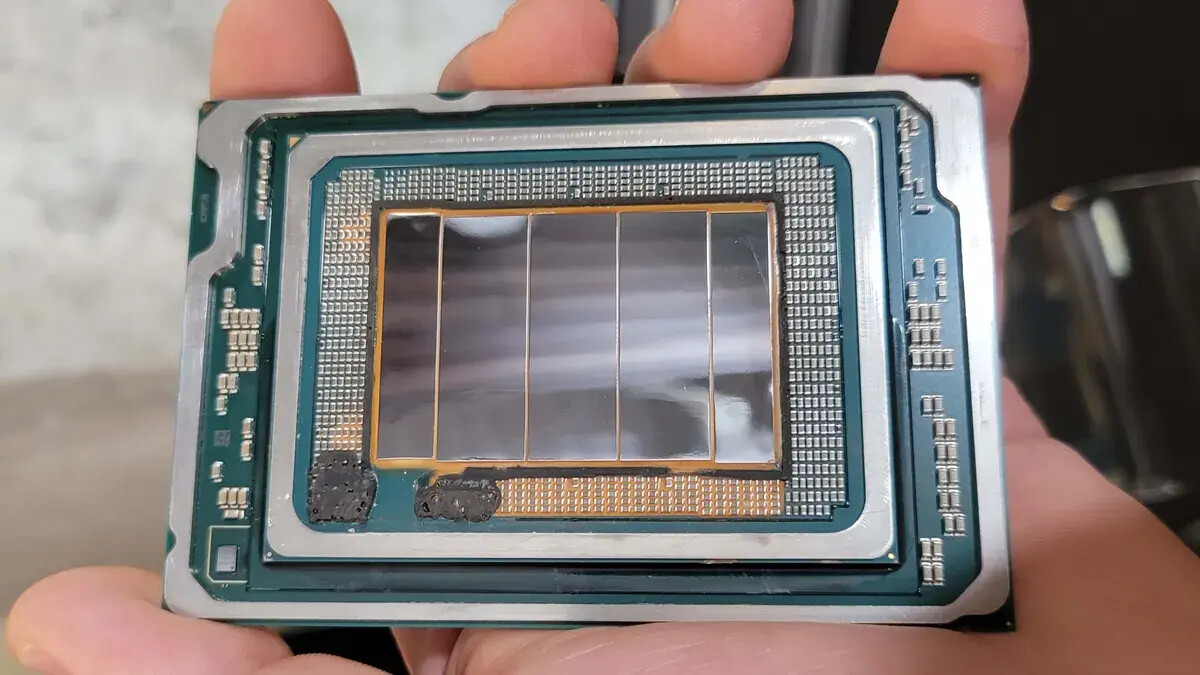

Równolegle pojawiły się informacje o nowym GPU o nazwie Jaguar Shores, który ma być następcą anulowanego projektu Falcon Shores. Intel planuje stworzyć pełnoprawne akceleratory AI na poziomie całych szaf serwerowych, ale jednocześnie pracuje nad zupełnie nową, oszczędną linią GPU dla centrów danych. Celem ma być obsługa mniej wymagających zadań obliczeniowych przy znacznie niższym poborze energii. To ruch w stronę niszy, gdzie konkurencja z NVIDIĄ jest mniej bezpośrednia, a przewagę buduje się nie mocą, lecz efektywnością kosztową i energetyczną.

Wrzesień przyniósł też sensacyjne doniesienia o rozmowach z Apple, który miałoby rozważać inwestycję kapitałową w Intela. Choć szczegóły nie zostały ujawnione, samo pojawienie się takiej opcji pokazuje, że firma aktywnie szuka nowych źródeł wsparcia i partnerstw, które pozwolą jej ustabilizować pozycję w kluczowych segmentach rynku.

Wszystkie te ruchy składają się na obraz firmy, która, choć w defensywie, nie rezygnuje z ambicji. Clearwater Forest pokazuje długofalową wizję w serwerach, Jaguar Shores ma być próbą powrotu do walki o GPU, a rozmowy z Apple sugerują, że Intel wciąż jest zbyt ważny, by ktokolwiek mógł go spisywać na straty.

Producenci OEM odpowiadają – infrastruktura gotowa na AI od Dell, HPE i Lenovo

Na rynku infrastruktury widać wyraźną zmianę roli producentów OEM. Dell, HPE i Lenovo coraz rzadziej prezentują serwery jako “goły” sprzęt. Zamiast tego oferują kompletne, zintegrowane platformy gotowe do obsługi sztucznej inteligencji.

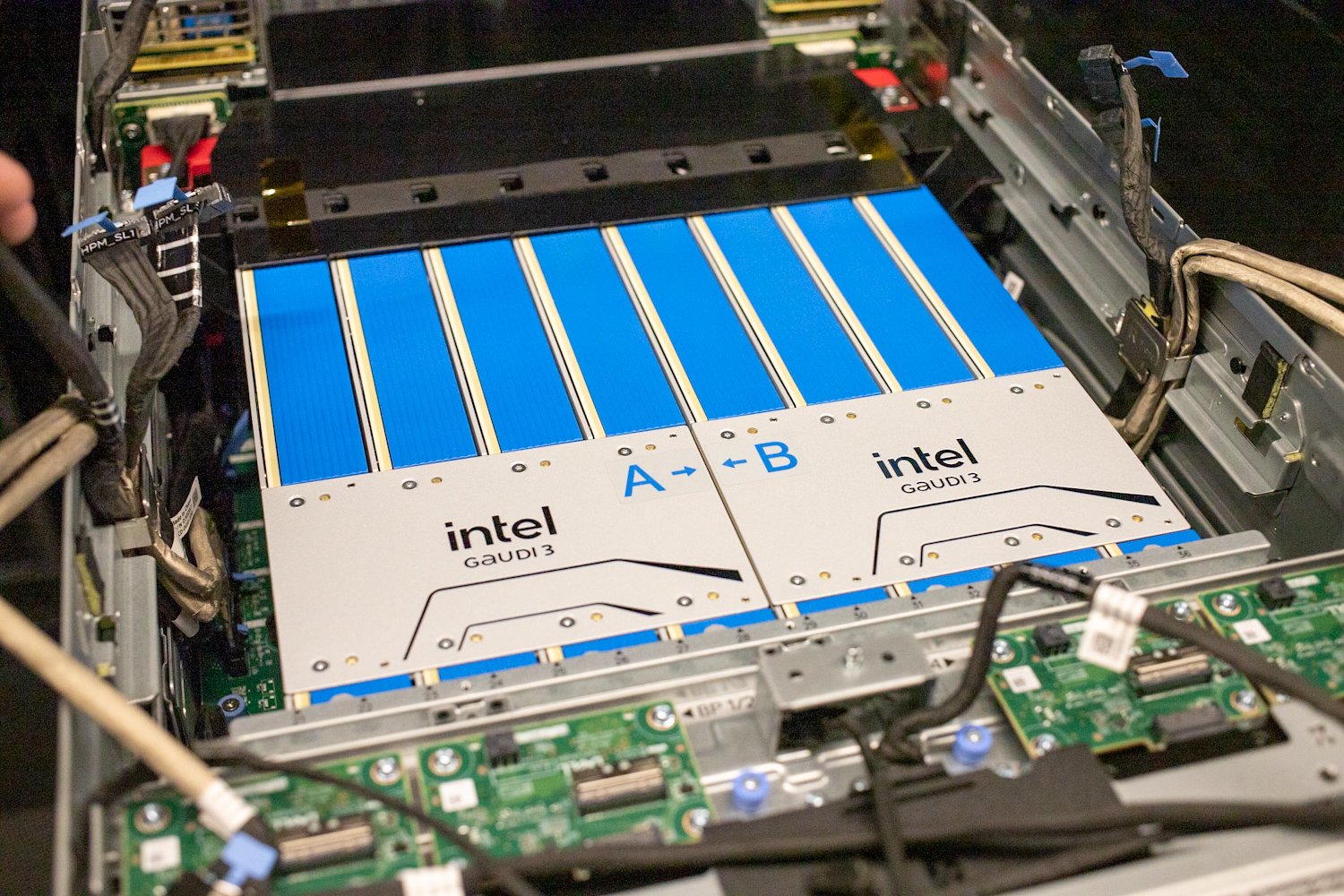

Dell Technologies ogłosił, że prognozuje w tym roku przychody ze sprzedaży serwerów AI na poziomie aż 20 miliardów dolarów. To sygnał, że popyt na infrastrukturę rośnie szybciej, niż wcześniej zakładano. Firma zaprezentowała też odświeżone portfolio rozwiązań dla chmury prywatnej, oparte na zdezintegrowanej architekturze, w której obliczenia, pamięć i sieć można skalować niezależnie. Platformy takie jak Dell Automation Platform czy Dell NativeEdge wzbogacono o funkcje automatyzacji opartej na AI i rozszerzone mechanizmy cyberodporności. Ważnym ruchem było także pierwsze komercyjne wdrożenie serwerów opartych o układy Intel Gaudi 3, co stawia Della w roli pioniera masowej dystrybucji tych akceleratorów.

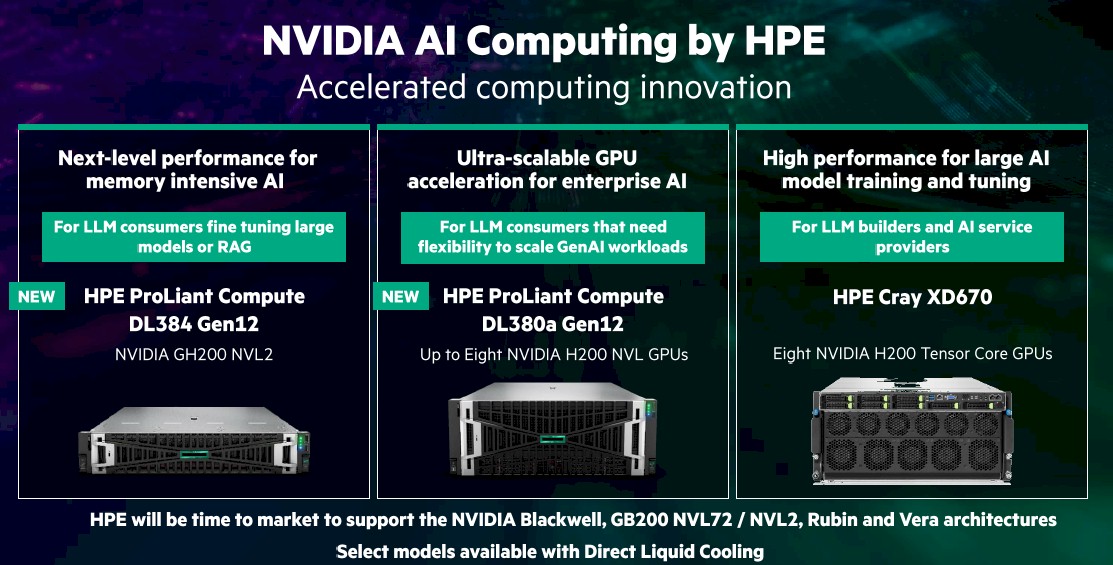

Hewlett Packard Enterprise przedstawił własną wizję “Agentic AI”, w której infrastruktura IT staje się inteligentna i autonomiczna. Centralnym elementem jest platforma HPE GreenLake Intelligence, wykorzystująca agentów AI do proaktywnego zarządzania i optymalizacji całego stosu IT. Uzupełnieniem oferty są nowe serwery ProLiant Gen 12, zoptymalizowane pod kątem akceleratorów NVIDIA Blackwell Ultra, oraz pamięć masowa Alletra Storage MP X10000, przygotowana do obsługi przepływów pracy AI dzięki wsparciu dla Model Context Protocol (MCP). To zestaw, który ma pomóc firmom w budowie hybrydowych środowisk AI. Od klasycznego centrum danych aż po chmurę.

Lenovo z kolei pogłębiło strategiczny sojusz z Nutanix, koncentrując się na rynku indyjskim. Wspólnie zapowiedziały lokalną produkcję serwerów wyposażonych w chłodzenie cieczą Lenovo Neptune i integrację z platformą Nutanix Kubernetes. Rozszerzono też ofertę rozwiązań ThinkAgile HX oraz pakiet “GPT-in-a-Box”, który umożliwia firmom budowę własnych, skalowalnych “fabryk AI”. Dzięki lokalizacji, produkcji i wsparciu dla nowoczesnych metod chłodzenia, Lenovo i Nutanix celują w klientów, którzy chcą wdrażać AI na dużą skalę, ale jednocześnie minimalizować koszty energii i chłodzenia.

Wspólna cecha tych trzech ogłoszeń jest oczywista: producenci OEM przestają rywalizować tylko mocą serwerów. Zamiast tego dostarczają gotowe receptury na infrastrukturę AI, w których sprzęt, oprogramowanie i usługi zarządzane łączą się w spójny pakiet. To także krok w stronę modeli subskrypcyjnych i usługowych, takich jak HPE GreenLake, gdzie klient płaci za wynik, a nie za sam sprzęt. Trend ten znacząco obniża barierę wejścia i sprawia, że adopcja AI w przedsiębiorstwach przyspiesza szybciej, niż zakładano jeszcze rok temu.

Nowości ze świata AI software: OpenAI, Databricks i Anthropic

Najwięksi gracze rynku oprogramowania udowodnili we wrześniu, że sztuczna inteligencja wchodzi coraz głębiej w procesy biznesowe, od pracy deweloperów po codzienne środowisko biurowe.

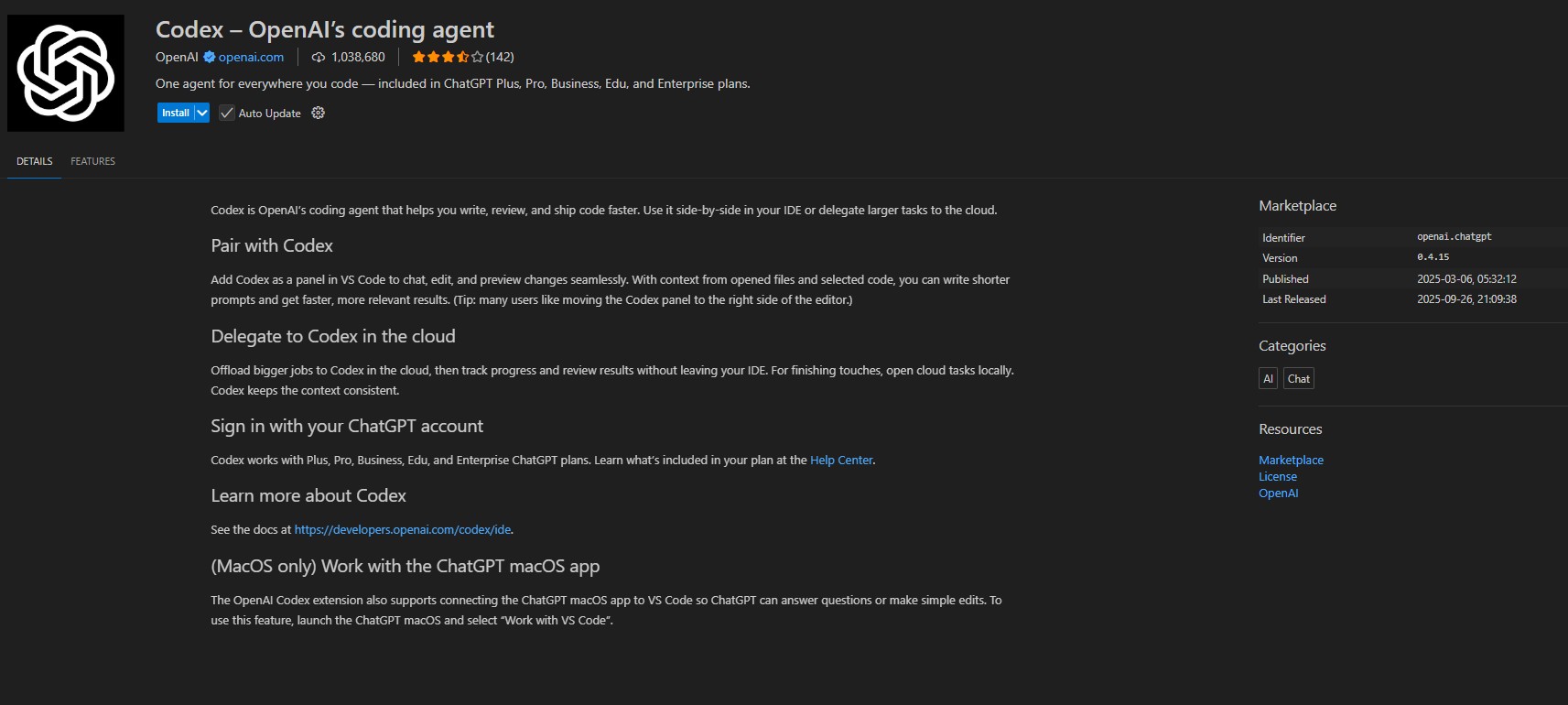

OpenAI zaprezentowało specjalistyczny wariant swojego flagowego modelu, GPT-5 Codex. To rozwiązanie zaprojektowane z myślą o inżynierach oprogramowania i “agentowym kodowaniu”. Model potrafi nie tylko generować fragmenty kodu, ale także autonomicznie realizować złożone zadania, takie jak refaktoryzacja całych repozytoriów czy przeprowadzanie przeglądów kodu w celu wykrywania krytycznych błędów. W praktyce oznacza to, że GPT-5 Codex może pracować nad projektem godzinami bez potrzeby interwencji człowieka, dynamicznie dostosowując sposób działania do trudności zadania. Model jest już dostępny w narzędziach OpenAI Codex oraz w ramach GitHub Copilot.

Kilka dni później ogłoszono, że OpenAI i Databricks zawarły wieloletnie partnerstwo o wartości 100 milionów dolarów. W efekcie modele OpenAI, w tym GPT-5, będą dostępne natywnie w platformie Databricks Data Intelligence oraz w narzędziu Agent Bricks. To ogromna zmiana dla ponad 20 tys. klientów Databricks, którzy zyskają możliwość budowania i skalowania aplikacji AI bezpośrednio na własnych, bezpiecznych danych korporacyjnych. Kluczowe jest to, że dane pozostają w środowisku klienta, model jest “przenoszony do danych”, a nie odwrotnie. Rozwiązuje to największy problem przedsiębiorstw: jak efektywnie wykorzystać potencjał LLM bez ryzyka związanego z przesyłaniem wrażliwych informacji do zewnętrznych API.

Swój ruch wykonał również Anthropic, który dodał do modelu Claude funkcję trwałej pamięci. Dzięki niej Claude zapamiętuje kontekst rozmów i projektów, co eliminuje konieczność ciągłego powtarzania tych samych informacji. Dodatkowo wprowadzono tryb “Incognito”, pozwalający prowadzić rozmowy bez zapisywania ich w historii, co jest kluczowe dla poufnych dyskusji. Równolegle Anthropic poinformował, że Claude został zintegrowany z Microsoft 365 Copilot, co od razu daje mu dostęp do milionów użytkowników biznesowych.

Wszystkie te ogłoszenia wpisują się w jeden trend: AI wchodzi do codziennych przepływów pracy. OpenAI celuje w deweloperów, Databricks otwiera drogę do bezpiecznego wykorzystania AI na danych korporacyjnych, a Anthropic stawia na prywatność i kontekst w narzędziach biurowych. Razem tworzą obraz rynku, w którym modele językowe przestają być ciekawostką, a stają się fundamentem pracy w przedsiębiorstwach.

Wrzesień 2025 pokazał, że sztuczna inteligencja nie jest już “innowacją przyszłości”, ale punktem odniesienia dla całej branży. Od procesorów i akceleratorów, przez gotowe platformy serwerowe, aż po software w codziennych narzędziach pracy, wszystko układa się w spójną mapę nowej infrastruktury IT. Firmy muszą dziś wybierać nie “czy”, ale “z kim” i “na jakich warunkach” wdrażać AI. To pytania, które będą definiować przewagi konkurencyjne w kolejnych latach.