Nowe układy, nowi gracze i… nowa rzeczywistość dla zespołów IT. Czerwiec przyniósł prawdziwą falę ogłoszeń, która pokazuje jedno: AI nie zwalnia, a firmy z każdej strony rynku technologicznego robią wszystko, by nie zostać w tyle. Jedni stawiają na potężne akceleratory i infrastrukturę, drudzy na inteligentne oprogramowanie, które ma usprawniać codzienną pracę.

W tym podsumowaniu zebraliśmy dla ciebie najważniejsze nowości, od ambitnych planów AMD, przez rewolucyjne ogłoszenia z Google I/O, aż po nowe modele AI i pierwsze efekty, jakie zaczynają przynosić w firmach na całym świecie. To wszystko w zwięzłej, przystępnej formie — bo świat IT nie czeka.

Nie tylko GPU – AMD wchodzi w sieci i superkomputery

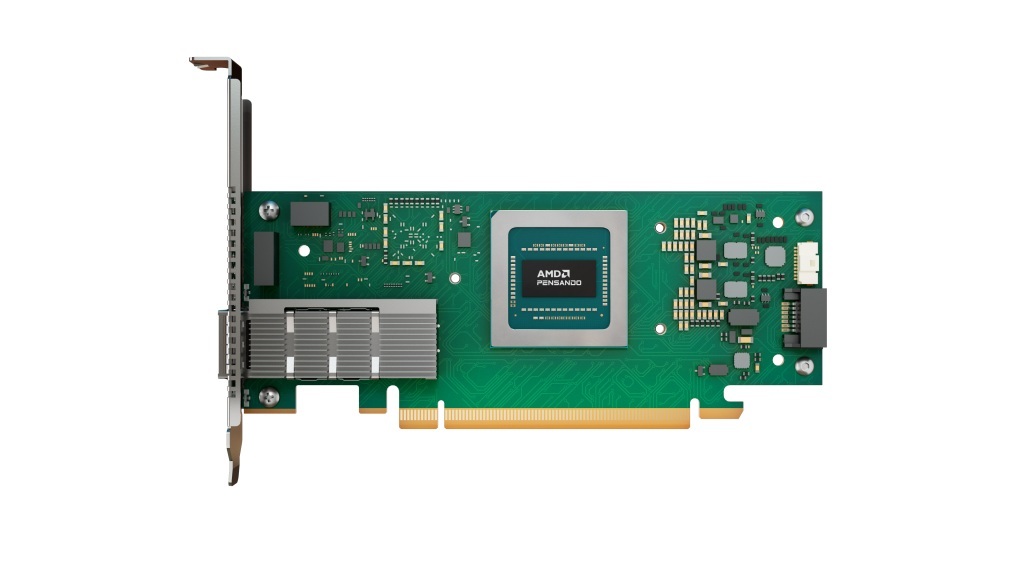

W czerwcu AMD udowodniło, że nie zamierza ograniczać się wyłącznie do procesorów i kart graficznych. Firma pokazała światu swoją pierwszą kartę sieciową Pensando Pollara 400 GbE, zgodną z nowym standardem Ultra Ethernet Consortium (UEC) 1.0. To bardzo istotny krok – do tej pory szybkie rozwiązania sieciowe w centrach danych były domeną NVIDII (Mellanox) i Intela. AMD dołącza do gry z zamiarem przejęcia części rynku infrastruktury AI.

Ale to dopiero początek. W roadmapie pojawiła się już wersja 800 GbE o nazwie „Vulcano”, której premiera planowana jest na 2026 rok. Co ciekawe, Oracle już potwierdziło, że będzie wykorzystywać karty AMD w swoich klastrach AI – obok akceleratorów Instinct MI350X, które również miały swoją premierę w czerwcu.

Na deser dostaliśmy też zapowiedź nowej generacji układów z serii Instinct MI400. Według wstępnych danych te akceleratory AI zaoferują aż 432 GB pamięci HBM4 i ponad 40 PFLOPS wydajności FP4, co stawia je na równi z najpotężniejszymi rozwiązaniami NVIDII. Razem z procesorami EPYC Zen 6 i otwartą architekturą UALink AMD buduje własną, kompletną platformę do obliczeń AI i HPC i wszystko wskazuje na to, że będzie mieć spore szanse na sukces.

Dlaczego to takie istotne? W nowoczesnych centrach danych dla AI sieć staje się jednym z kluczowych ogniw – zwłaszcza gdy mówimy o łączeniu dziesiątek, a czasem setek GPU i akceleratorów. Modele językowe o miliardach parametrów nie tylko wymagają mocy obliczeniowej, ale też błyskawicznej wymiany danych między węzłami. 400 czy 800 GbE to nie tylko większa przepustowość, ale też mniejsze opóźnienia, lepsza synchronizacja trenowania modeli i niższy narzut CPU.

Dla firm budujących własne klastry AI, czy to do przetwarzania danych, czy rozwoju LLM, to szansa na większą wydajność bez uzależniania się od jednego dostawcy infrastruktury. A dla AMD? Wejście w niszę, którą przez lata zdominowała NVIDIA.

Google I/O 2025: pełna ofensywa AI w pracy i biznesie

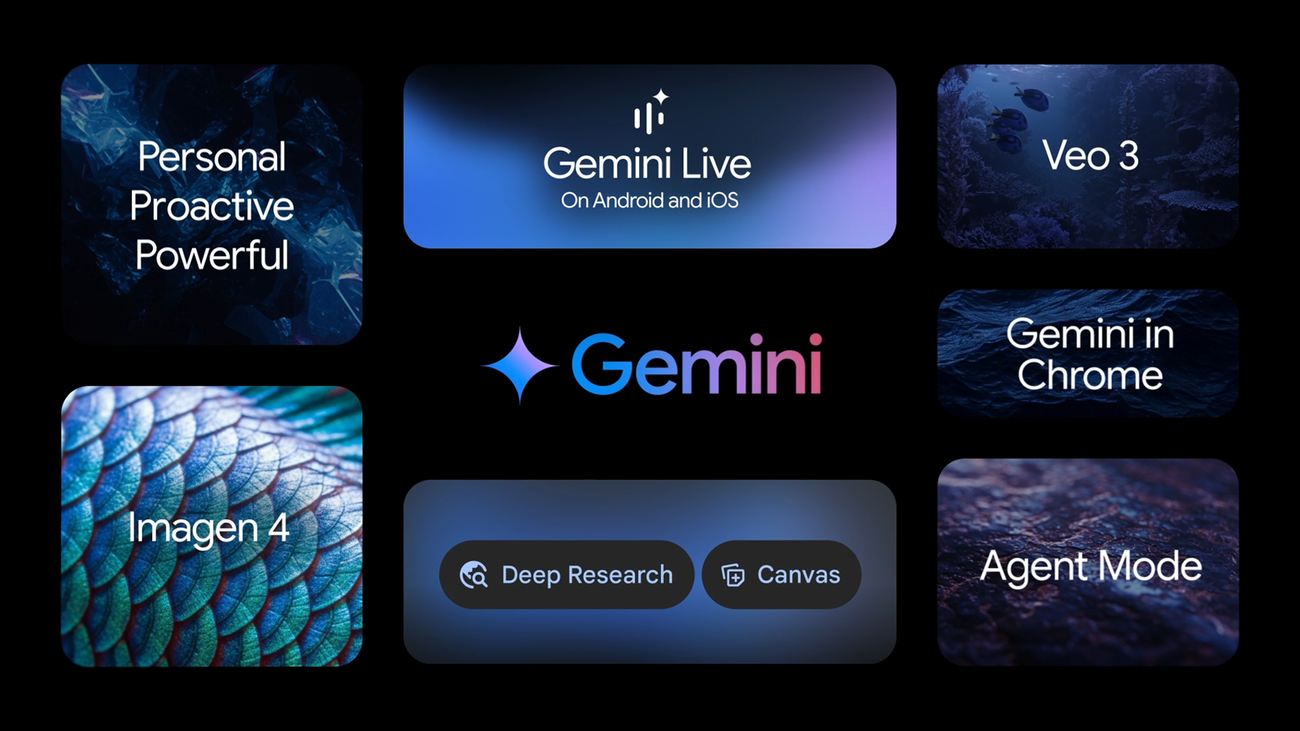

Google postawiło na I/O 2025 jasny cel: AI ma działać proaktywnie, nie tylko podpowiadać. Największym hitem była nowa funkcja Agent Mode w aplikacji Gemini – wspierana przez Project Mariner. Firma zaprezentowała możliwość przekazania AI wykonania całego procesu, np.: „przygotuj prezentację z ostatniego spotkania i wyślij ją zespołowi” i powierzenie całego ciągu działań AI. Gemini potrafi samodzielnie przeszukać dokumenty, zebrać informacje, stworzyć prezentację i rozesłać ją we właściwym formacie do odpowiednich osób. Co więcej, narzędzie potrafi już uczyć się powtarzalnych czynności po jednokrotnym pokazaniu („teach & repeat”) i obsługiwać do 10 zadań jednocześnie. Jedyny minus jest taki, że na pełną funkcjonalność będziemy musieli poczekać, ale premiera ma nastąpić jeszcze w tym roku.

Dla użytkowników biznesowych to zmiana jakościowa – mniej klikania, więcej działania, zwłaszcza w środowiskach pracujących w Google Workspace. Co ważne, Google nie zamyka tego rozwiązania wyłącznie w swoich narzędziach. Zapowiedziano także otwarte API, co otwiera drzwi do integracji z systemami CRM, ERP czy workflow automation.

Gemini wymodelowane przez Magnum I/O zostało dodatkowo wzmocnione. Nowa wersja Gemini 2.5 Pro i Flash zyskała funkcje „Deep Think” do realizacji złożonych zadań i obsługę multimodalności (tekst-obraz-dźwięk). Google zadbało też o kontrolę bezpieczeństwa i transparentność. Dodatkowo wprowadziło też tzw. „budżety tokenów” – to coś w rodzaju limitu zasobów, jakimi dysponuje AI podczas wykonywania zadania. Dzięki temu użytkownik lub firma może lepiej kontrolować, ile informacji AI może przetworzyć i jak długo będzie pracować nad danym tematem. To nie tylko kwestia wydajności, ale też bezpieczeństwa i przewidywalności działania.

Drugim dużym ogłoszeniem było odświeżenie i otwarcie aplikacji NotebookLM – narzędzia do pracy z dokumentami, które teraz potrafi działać jak kontekstowy analityk. Wystarczy wgrać dokumentację, dane, notatki ze spotkań czy prezentacje, a NotebookLM sam zaproponuje podsumowania, analizy czy ułatwi tworzenie nowych treści. Co więcej – narzędzie działa lokalnie, co oznacza pełną kontrolę nad danymi i możliwość integracji z wewnętrznymi repozytoriami firmowymi.

Google celuje w to, by AI stała się nie tylko podpowiedzią, ale rzeczywistym wykonawcą zadań. A jeśli inne firmy pójdą tą samą drogą – to może być początek realnej transformacji sposobu pracy biurowej.

Nie tylko Google rozwija swoje AI

Choć Google gra pierwsze skrzypce na scenie AI, inni gracze również nie spuszczają nogi z gazu. Czerwiec przyniósł sporo ogłoszeń od firm, które już dziś tworzą realne rozwiązania dla biznesu – od automatyzacji zadań, przez analizę danych, po tworzenie własnych modeli wewnętrznych.

Zacznijmy od Anthropic, które oficjalnie udostępniło światu Claude 4 – model zdolny nie tylko rozumieć bardzo złożone zapytania, ale również samodzielnie pracować nad zadaniami przez wiele minut, a nawet godzin, bez konieczności ciągłego „prowadzenia za rękę”. W praktyce oznacza to, że Claude może zająć się np. analizą danych, tworzeniem raportów czy podsumowaniem dużych dokumentów – tak jak zrobiłby to asystent biurowy. Co ważne, model jest zoptymalizowany pod kątem prywatności i stabilnej pracy w środowiskach korporacyjnych.

Z kolei Microsoft ogłosił, że przeszkolili już 100 tysięcy pracowników w zakresie korzystania z Copilotów opartych o modele GPT – to pokazuje, jak szybko firmy adaptują narzędzia AI w codziennej pracy biurowej i analitycznej. Ich przykład idzie w parze z nowym rozwiązaniem od Mistral AI – europejskiego gracza, który zaprezentował własnego Enterprise Copilota, działającego lokalnie, w pełni prywatnie i bez potrzeby wysyłania danych do chmury.

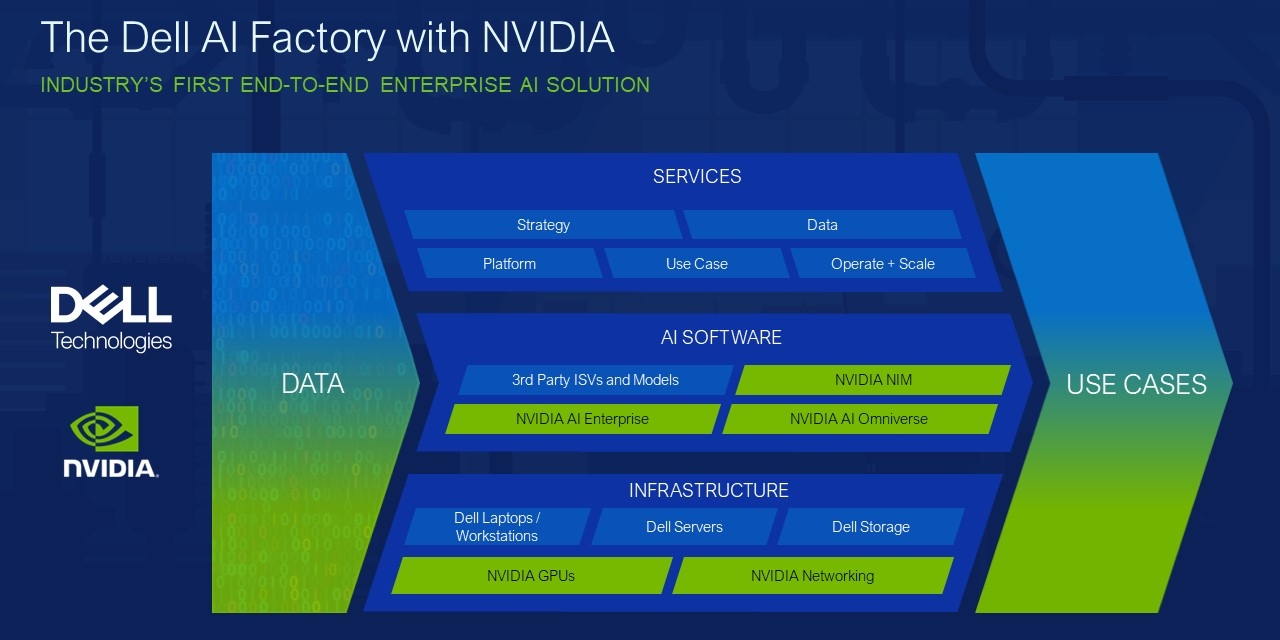

Warto wspomnieć też o Dell Technologies, które postanowiło pójść o krok dalej i zaoferować firmom gotowe rozwiązania sprzętowo-programowe. Ich AI Factory to modułowe, prefabrykowane centra obliczeniowe – zestawy AI do wdrożenia „pod klucz” w każdej większej organizacji. Dla firm, które nie chcą budować całej infrastruktury od zera – to może być gamechanger.

Na horyzoncie pojawiła się również potencjalna bomba – według przecieków Apple rozważa przejęcie Perplexity AI, czyli konkurenta Google’a w obszarze AI-asystentów. Jeśli do transakcji dojdzie, może to oznaczać poważne wzmocnienie pozycji Apple w biznesowym wykorzystaniu generatywnej AI – także w systemach zamkniętych i prywatnych.

NVIDIA znów najcenniejszą spółką świata

Ekosystem narzędzi AI dla firm szybko się rozrasta, a coraz więcej dostawców oferuje rozwiązania, które można realnie wdrożyć „tu i teraz” – bez eksperymentów, bez czekania, bez nadziei. To już nie przyszłość – to codzienność.To oficjalne – NVIDIA powróciła na szczyt jako najdroższa spółka giełdowa na świecie. W czerwcu jej kapitalizacja sięgnęła około 3,77 biliona USD, wyprzedzając Microsoft i Apple – wszystko dzięki gigantycznemu popytowi na rozwiązania AI i dominacji w segmencie centrów danych.

Nie chodzi jednak tylko o wartość rynkową. NVIDIA ogłosiła rozpoczęcie realizacji superkomputera Blue Lion we współpracy z HPE i niemieckim Leibniz Supercomputing Centre – ten potężny klaster będzie oparty na nowych chipach Vera Rubin. To jasny dowód, że NVIDIA nie tylko sprzedaje GPU, tworzy cały ekosystem infrastruktury AI i systemów HPC opartych na własnych procesorach.

Dodatkowo Reuters i Barron’s doniosły, że inwestorzy chwalą nowości takie jak nadchodzące generacje chipów (Blackwell Ultra, Rubin i Rubin Ultra), które mają przyspieszyć rozwój AI i utrzymać przewagę technologiczną firmy. Analitycy Loop Capital nawet podnieśli target cenowy NVIDIA do 250 USD za akcję, co przy obecnych wycenach sugeruje wycenę rynkową aż 6 bilionów USD.

Jak AI zmienia rynek pracy

Sztuczna inteligencja przestaje być narzędziem wspierającym – coraz częściej przejmuje kluczowe obowiązki, a firmy jawnie to przyznają. Na przykład Amazon ogłosił, że automatyzacja spowodowana AI doprowadzi do redukcji niektórych stanowisk biurowych, podczas gdy Salesforce przesunął 500 osób z obsługi klienta do innych działów dzięki wzrostowi produktywności (oszczędność ~50 mln USD)… i to dzięki AI, nie redukcjom funkcjonalnym.

Ale to nie są tylko korporacyjne deklaracje, dane potwierdzają trend. Globalny raport Bitrix24 „Przyszłość pracy w 2050 roku” wskazuje, że do połowy wieku, AI zdominuje rekrutację, przejmując selekcję kandydatów, prowadzenie rozmów i onboarding. Eksperci spodziewają się, że większość spotkań biznesowych odbędzie się w metawersum, a tradycyjne biuro będzie rzadkością – co prowadzi do całkowitej redefinicji struktur i modeli zatrudnienia w firmach.

Dla działów HR i kierowników projektów to znak alarmowy – warto zacząć wprowadzać automatyzację już dziś, bo inaczej firmy mogą zostać z tyłu, a procesy rekrutacyjne, onboardingu i współpracy staną się mniej konkurencyjne.

Komputery kwantowe w natarciu

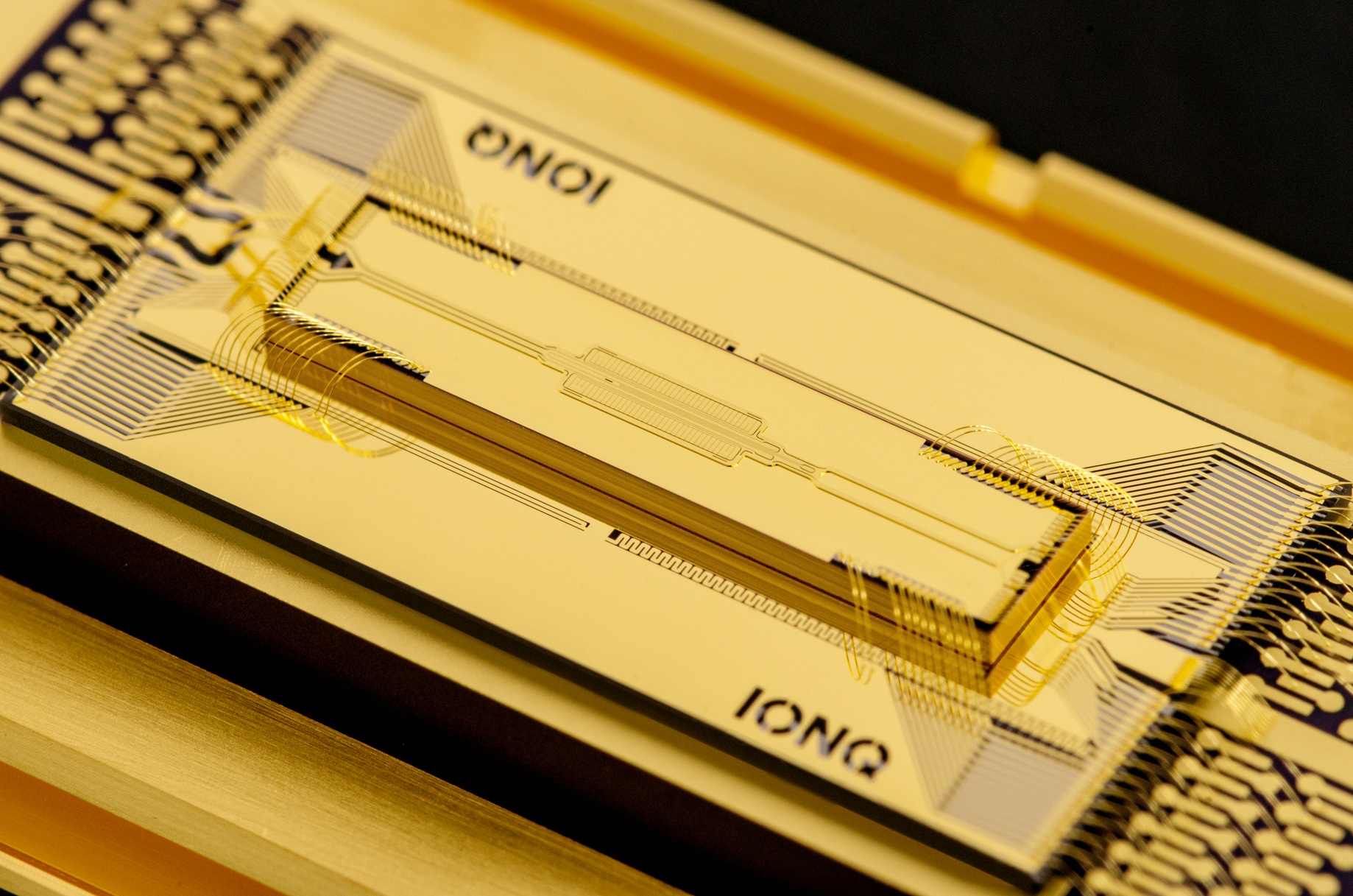

Chociaż to AI kradnie show, w cieniu odbywa się coś równie przełomowego – komputery kwantowe z każdym miesiącem coraz mocniej zaznaczają swoją obecność w realnym biznesie. Czerwiec przyniósł aż kilka ważnych informacji z tej dziedziny.Na początek duży ruch ze strony IonQ, które ogłosiło przejęcie brytyjskiego Oxford Ionics za ponad miliard dolarów. To nie tylko największa transakcja w historii kwantowych startupów, ale też jasny sygnał: technologia pułapek jonowych właśnie dostała potężny zastrzyk finansowy i organizacyjny. IonQ zapowiada, że do 2026 roku ich maszyny osiągną 256 fizycznych kubitów, a w kolejnych latach – nawet miliony.

Z kolei IBM ujawnił plan budowy systemu Quantum Starling, czyli kwantowego superkomputera z 200 kubitami logicznymi, który ma być odporny na błędy. Premiera? 2029. Ale co ważne – roadmapa już jest, budowa trwa, a IBM pokazuje, że myśli o zastosowaniach biznesowych, nie tylko badaniach.

A jeśli ktoś myśli, że to wszystko melodia przyszłości, to niech zastanowi się ponownie. D-Wave już teraz wprowadza na rynek kolejną generację swojego sprzętu. Advantage2 ma ponad 4400 kubitów i jest dostępny zarówno w chmurze, jak i lokalnie. To nie są ogłoszenia – to gotowe narzędzia, które można wdrażać np. w optymalizacji czy przetwarzaniu złożonych modeli.

WARTO WIEDZIEĆ:

Kubit kubitowi nierówny. Kubit to odpowiednik klasycznego bitu w komputerze, ale w wersji kwantowej i może być jednocześnie w stanie 0 i 1 dzięki zjawisku superpozycji. Im więcej jednostek dostępnych, tym więcej informacji komputer kwantowy może przetwarzać jednocześnie. Teoretycznie moc obliczeniowa komputera kwantowego rośnie wykładniczo wraz z liczbą kubitów. Choć wszystkie komputery kwantowe posługują się tymi samymi jednostkami, ich zastosowanie i działanie zależą od technologii, na której bazują. Nie chodzi więc tylko o liczbę kubitów, ale o to, do czego komputer jest zdolny. To trochę jak porównywać liczbę rdzeni w CPU z ilością jednostek obliczeniowych GPU. Inne narzędzia do innych zadań. Dla przykładu komputery kwantowe D-Wave wyspecjalizowane są do rozwiązywania złożonych problemów optymalizacyjnych, a te od IBM, Umożliwiają uniwersalne obliczenia kwantowe – można je zaprogramować podobnie jak klasyczne procesory.

I na koniec: Polska też zaznaczyła swoją obecność na kwantowej mapie świata. W czerwcu w Poznaniu uruchomiono pierwszy europejski komputer kwantowy PIAST-Q – oparty również na technologii pułapek jonowych. To część programu EuroHPC, który ma na celu rozwój niezależnej infrastruktury obliczeniowej w Europie. Sprzęt już działa, a jego możliwości badawcze mają być udostępnione m.in. firmom technologicznym i ośrodkom naukowym.

Może jeszcze nie dziś, ale za kilka lat komputery kwantowe staną się częścią infrastruktury

IT. Szczególnie tam, gdzie potrzeba ekstremalnej mocy obliczeniowej. Warto więc zacząć śledzić tę technologię już teraz.